Trusted Learning Analytics beruhen auf vertrauensvollen Beziehungen zwischen Anwendern und Nutzern

FRAGEN AN (II/II) Hendrik Drachsler, Professor an der Goethe-Universität Frankfurt und Leiter des Arbeitsbereichs „Educational Technologies“ am DIPF | Leibniz-Institut für Bildungsforschung und Bildungsinformation, der sich nicht nur mit Bildungstechnologien auseinandersetzt, sondern auch daran arbeitet Learning Analytics an deutsche Hochschulen zu bringen. In angelsächsischen Ländern ist das Messen, Sammeln und Analysieren von Daten über Lernende und deren Kontexte bereits seit über zehn Jahren fester Bestandteil von Universitäten. Learning-Analytics-Anwendungen und -Methoden werden – oft sogar in eigenen Departments – eingesetzt, um das Lernen besser zu verstehen und zu optimieren. Doch einen entscheidenden Unterschied gibt es: Drachsler betreibt „Trusted Learning Analytics“. Das bedeutet, dass der Umgang mit Daten Studierender nicht nur ethisch verantwortbaren und humanistischen Prinzipien folgt, sondern auch den strengen deutschen Datenschutzrichtlinien.

Das achtköpfige Educational Technologies-Team am DIPF

Herr Drachsler, seit wann spricht man von Learning Analytics?

Der Begriff Learning Analytics ist entstanden durch die wachsende Nutzung digitaler Medien und der dabei entstehenden Logdaten. Eigentlich sind Logdaten ja für das Monitoring eines Computerprogramms gedacht, um im Zweifelsfall entsprechend eingreifen zu können. Irgendwann hat man dann realisiert, dass dabei auch das Lehrerverhalten mitgeschrieben wird. Daraus entwickelte sich die Idee, die Logfiles auch in dieser Hinsicht auszuwerten und alternativ zur qualitativen Beobachtung des Lehrerverhaltens oder zu stark intervenierenden Testverfahren einzusetzen. Vor etwa zehn Jahren hoffte man dann, überhaupt keine Assessments mehr zu benötigen – man glaubte bereits alle Daten zu haben. Heute ist man klüger und weiß, dass Learning Analytics nur Teilbereiche beleuchten. (lacht)

„Die Verfahren und Methoden von Learning Analytics bieten neue Datenquellen für qualitative und quantitative Methoden der Bildungsforschung.“

Mit dem Boom von Big Data, der Leistungsfähigkeit von Computern und den heute entwickelten Konzepten erweitern sich die Möglichkeiten aus vorhandenen Daten neue Erkenntnisse abzuleiten allerdings enorm – und wir haben jetzt die Infrastruktur für Anwendungen der Künstlichen Intelligenz, die bereits vor 50 Jahren erfunden wurden.

Dimensionen von Learning Analytics

Wofür steht “trusted”?

Dass wir Datenschutz und einen ethisch verantwortbaren, humanistischen Umgang von Anfang an ganz konsequent mitdenken! Wir sind überzeugt davon, dass man Learning Analytics von Beginn an auf der Basis einer vertrauensvollen Beziehung zwischen Anwendern und Nutzern gestalten kann und Nutzer jederzeit die Kontrolle über ihre eigenen Daten haben können. Wir haben sechs Dimensionen herausgearbeitet, die bei Entwicklung und Einsatz von Trusted Learning Analytics bedeutsam sind: Zielgruppen, Ziele, Datenquelle und Datenart, Technologien, ethische Aspekte und Datenschutz sowie Informationskompetenz.

Wo können Learning-Analytics-Methoden Lehrende konkret unterstützen?

Ein ganz einfaches Beispiel: Bislang teilen Lehrende in Seminaren ihr Material aus, diskutieren mit den Studierenden darüber und am Ende wird eine Klausur geschrieben. Was dazwischen passiert, also wer welches Material wie nutzt, wird im Grunde nicht betrachtet. Mit der zunehmenden Nutzung von digitalen Medien und den dabei entstehenden Daten können wir darstellen, wie das Material für bestimmte Aufgaben angenommen wird – wir können quasi Vogelperspektiven auf bestimmte Lernsituationen einnehmen. Nehmen wir mal Forumsdiskussionen beim Lernen in Online-Umgebungen wie Moocs: Um zu verstehen wie die Teilnehmer interagieren, muss ich mir nicht mehr jeden Forumspost durchlesen, sondern kann über ein Plug-In das Tool „Social-Network-Analyse“ einbauen und darüber sehen, wer zu welcher Gruppe gehört, wie sie zusammenarbeitet, wer auf wen antwortet und welche Studierenden außerhalb des Geschehens sind.

„Lernende bekommen direktes Feedback zu ihren Aktivitäten und können hilfreiche Tipps erhalten.“

Wenn es nun mein Ziel ist, in Kleingruppen bestimmte Inhalte zu erarbeiten, erwarte ich ein bestimmtes Muster. Sehe ich dann Satelliten, weiß ich, dass nicht alle in die Aktivitäten eingebunden sind und kann diese Personen direkt fragen, vor welchen Hindernissen oder Problemen sie gerade stehen.

Können auch Studierende davon profitieren?

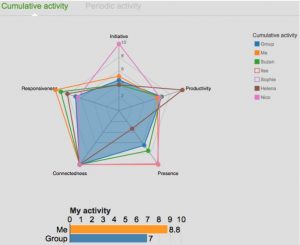

Kumulative Ansicht des Social-Network-Analysetools

Wenn ich als Dozent einen Kurs halte, den schon mehrere Kohorten von Studierenden belegt haben, kann ich aufgrund der bestehenden Datenbasis mit Learning-Analytics-Methoden ableiten, welches Studierverhalten erfolgreich ist und welches weniger. Angesichts der bisher in einem Seminar investierten Zeit könnte ein Recommender-System einer Studentin frühzeitig das Feedback geben, sich einer Lerngruppe anzuschließen oder die Aufgabenkomplexe B und C noch einmal zu bearbeiten. Ob das Feedback angenommen wird oder nicht, ist natürlich die individuelle Entscheidung des Studierenden. Anderes Beispiel: Wir haben ein Tool für Gruppenarbeit im Online-Umgebungen entwickelt, das studentische Arbeitsprozesse ziemlich gut unterstützen kann. Bei der Gruppenarbeit erlebt man ja oft, dass zwei oder drei die Arbeit machen und der Rest zuschaut, das Engagement also ungleich verteilt ist. Das führt in der Regel zu Frust innerhalb der Arbeitsgruppe und eventuell auch zu negativen Bewertungen. Unser Social-Network-Analyse-Tool beruht auf fünf Indikatoren, über die das kommunikative Geschehen der Gruppenarbeit in einem Spiderdiagramm dargestellt wird:

Das Gruppenverhalten wird über fünf Indikatoren dargestellt: Initiative, Responsiveness, Produktivität, Content und Connectivity.

Jedes Gruppenmitglied kann also die eigenen Aktivitäten und die der anderen beobachten und sein Verhalten danach ausrichten – vorausgesetzt, die Studierenden haben ihren Privacy-Button ausgeschaltet. Eine Teilnehmerin, die beispielsweise besonders oft die Initiative ergreift, kann so einen anderen Teilnehmer darauf hinweisen, dass er nun an der Reihe ist.

Das Social-Network-Analysetool als Moderator?

Als wir das Tool erprobt haben, haben wir eine sehr interessante Beobachtung gemacht: Keiner der Studierenden nutzte den Privacy-Modus, was letztendlich dazu führte, dass sich die Teilnehmenden aktiver an der Gruppenarbeit beteiligten und die Arbeit gleichmäßiger verteilt wurde. Und es traten viel weniger gruppendynamische Konflikte auf. Erschreckend war allerdings, wie schnell die Studierenden diese Protokollierung als „wahr“ empfunden haben. Denn es gibt ja auch schwache Indikatoren, die nur Teilbereiche einer komplexeren Situation spiegeln. Unser Indikator „Initiative“ wertet zum Beispiel nur aus, wer als erster was postet, der Indikator „Responsiveness“ sagt lediglich aus, wie oft ich auf was geantwortet habe. Über den Gehalt eines Beitrags ist damit noch nichts gesagt.

Mehr zu Trusted Learning Analytics

- Vortrag von Hendrik Drachsler im Rahmen der „Lecture Series“ des Grade Center Education an der Goethe-Universität Frankfurt am Main im SS 2019

- Trusted Learning Analytics, Beitrag von Hendrik Drachsler in der Zeitschrift Synergie, dem Fachmagazin für Digitalisierung in der Lehre (Ausgabe #7 vom September 2018)

- Dossier „Learning Analytics“ des Hochschulforum Digitalisierung

Blindes Vertrauen ist also nicht angesagt?

Eher nicht! Unser Ansatz von „Trusted“ sieht deshalb vor, verwendete Indikatoren immer so transparent zu beschreiben, dass man sie kritisch reflektieren kann. Auch die Frage der Zweckentfremdung muss im Grunde immer mitgedacht werden, denn sobald so ein Instrument in der Welt ist, weckt es auch Bedürfnisse – und zwar oft für andere Settings als die intendierten. Dozenten haben uns gesagt, dass sie dieses Tool gerne für die Bewertung von Seminararbeiten nutzen würden. Da muss man ganz klar sagen: Das ist nicht das Ziel! Es ist als Unterstützung für Studierende und nicht als Assessment-Tool gedacht.

„Es besteht immer die Gefahr der Zweckentfremdung.“

Deswegen müssen wir für Learning Analytics ganz klare Verhaltensregeln festlegen. Aktuell arbeiten wir an einem Verhaltenskodex, um unsere Vorstellung zum Einsatz von Learning Analytics einzubringen – Learning Analytics als Tool, das wir im Sinne des humanistischen Bildungsbegriffs zur Lösung aktueller Probleme in Deutschlands Bildungssystem einbringen wollen. Dabei geht es nicht um Kontrollmechanismen, sondern vor allem um eine neue Feedback-Kultur!

Vielen Dank für das Gespräch, Herr Drachsler!

________________________________________________________________________

Dieser Text steht unter der CC BY 4.0-Lizenz. Der Name des Urhebers soll bei einer Weiterverwendung wie folgt genannt werden: Christine Schumann für Deutscher Bildungsserver

________________________________________________________________________

Auch noch interessant

- Wir fragen danach, ob neue Technologien das Lernen effizienter, effektiver und attraktiver machen.“ Mit Educational Technologies Lernprozesse fördern und Leistungen verbessern. FRAGEN AN (I/II) Hendrik Drachsler, Professor an der Goethe-Universität Frankfurt und Leiter des Arbeitsbereichs „Educational Technologies“ am DIPF | Leibniz-Institut für Bildungsforschung und Bildungsinformation.

- „Bereits in drei bis fünf Jahren werden Methoden der Künstlichen Intelligenz die Hochschulbildung verändert haben“. Projekt der FernUniversität in Hagen will mit maschinellem Lernen und wissensbasiertem Expertensystem individuelles Lernen und Studienorganisation unterstützen. NTERVIEW mit Prof. Dr. Claudia de Witt von der FernUniversität in Hagen.

- „Wie füttert man Algorithmen?“ Hintergründe zum Einsatz Künstlicher Intelligenz in der Bildungsforschung. Ein Beitrag von Carolin Anda, DIPF.